以前看电影里的机器人啥都能精准抓取、分毫不差地装配,总觉得是特效。现在去现代化工厂转一圈,嚯,满眼都是这种场景,机器臂灵活得像人手一样,从一堆杂乱零件里“信手拈来”。这背后啊,可不是魔法,而是给机器安上了一双“智慧之眼”——3D工业相机。但你可别小看这双“眼睛”,想让机器在复杂、高速甚至恶劣的环境里看得清、认得准、反应快,里面的门道深了去了。今天咱就唠唠那些让这双“眼睛”真正变得犀利的3D工业相机关键技术。

最早给机器装“眼睛”的时候,想法挺简单:相机只管拍照,把海量的图像数据一股脑儿传给远处的电脑(工控机)去分析。这就好比你的眼睛看到东西,得打个电话请示千里之外的大脑,等指令传回来,黄花菜都凉了。在分拣、装配这些争分夺秒的环节,这种延迟就是致命的短板,不仅慢,系统还复杂脆弱-1。

现在好了,关键突破来了:把一颗强大的AI芯片直接塞进相机里。这就等于给“眼睛”配了个“本地大脑”(专业点叫“边缘AI整合”)。像有些前沿的3D相机,里面直接集成了多核CPU和专用的神经网络处理器(NPU),运算能力能达到每秒数万亿次-1。它能在拍摄的瞬间,自己就在现场完成识别、测量和判断,结果直接指挥机械臂动作。这么一来,反应速度是毫秒级的,系统也简化到一根网线就能供电和传输数据,稳定又高效-1。以前这种高端系统动辄上万美元,现在随着技术规模化,几千元人民币也能拿下,让更多工厂用得起-1。这可以说是3D工业相机关键技术从“看得见”迈向“看得懂”并“即时决策”的第一块基石。

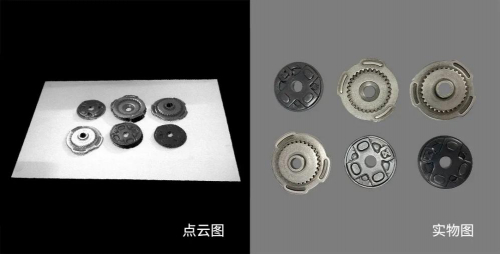

工厂里的东西可不是都规规矩矩的。亮闪闪的金属零件、透明的玻璃瓶、黑乎乎的橡胶件,这些在传统3D相机看来简直就是“隐身”或“失真”的难题。单一的技术路线,比如只靠激光扫描或结构光,遇到这些特殊表面就抓瞎,要么反射光太强“亮瞎眼”,要么没有反射信号“看不见”-1。

怎么办呢?现在的解法非常聪明,叫做“混合深度技术”和“多传感器融合”。简单说,就是不只用一种“眼光”去看。好比人眼在暗处看不清,我们还会用手去摸一下确认形状。先进的3D工业相机也这样,它可能同时结合了结构光、立体视觉,甚至还内置了RGB彩色摄像头和运动传感器(IMU)-1。更绝的是,再通过AI算法,把这些不同渠道获取的信息——深度、纹理、颜色、相对运动——进行融合、互补与智能修正-1。如此一来,无论是反光的车漆、透明的药瓶,还是无纹理的黑色泡沫,都能生成完整、准确的三维模型。这项3D工业相机关键技术,真正解决了工业现场最头疼的材质适应性问题,让自动化不再“挑食”-4。

技术再牛,如果太贵、太难用,也只能躺在实验室。早期的3D视觉方案往往是为某个特定环节(比如质检)定制的“单兵武器”,换个任务就得全套更换,费钱费时-1。

现在的趋势是打造“多功能视觉平台”。一台3D工业相机,通过统一的软件平台(SDK)和标准接口(如支持ROS、Ethernet等),今天可以调去引导机器人抓取,明天就能软件升级变成高精度检测仪-1-4。这种灵活性,得益于底层硬件设计的模块化和标准化,以及软件算法的可重构性。厂商通过优化设计、共用核心组件来大幅降低成本(Design-for-Cost)-1。同时,软件也变得越来越“傻瓜化”,有的甚至提供图形化编程界面,工程师拖拖拽拽就能搭建应用,大大降低了开发门槛和周期-4。

这意味着,企业可以用合理的成本组建一个3D视觉“军团”,分散到流水线的各个环节,并且能随时根据生产需求调整“兵力部署”。这种易于规模化、柔性化的特性,正是3D工业相机关键技术走向普及、赋能广大中小型制造企业的关键一步-1。

这双“眼睛”还在不断进化。为了追求极致的速度,一种模仿生物视网膜的“事件相机”开始被探索与3D视觉结合,它只关注变化的像素,能在微秒级捕捉高速运动-3。而为了获得极致的精度和真实感,像NeRF(神经辐射场)这样的AI技术,能从多个2D图片中直接生成细腻的3D模型,在数字孪生和高端检测中潜力巨大-3。甚至,科学家们正在研究把激光接收器(SPAD阵列)和计算单元集成到一颗“光子芯片”上,让三维感知的速度和能效比再上一个台阶-3。

1. 网友“机械攻城狮”提问:我们厂想做零件抓取自动化,但零件有反光也有哑光的,现场光线也复杂。看了文章,是不是选有“混合深度技术”的3D相机就行?具体该怎么选型?

答:这位师傅的问题非常具体,点出了选型的核心挑战。您说的没错,优先选择具备混合深度技术(比如结合结构光与立体视觉)并强调能处理反光/暗色物体的相机品牌和型号是关键第一步-1。

具体选型时,您可以像医生问诊一样,问自己几个问题:第一,看工作距离和精度:零件离相机多远?需要多高的抓取定位精度(例如是±0.1mm还是±1mm)?这决定了选择何种原理(结构光精度高但工作距离相对近,双目立体视觉工作距离更灵活)-3。第二,看节拍要求:生产线节拍多快?这决定了需要相机的帧率(每秒处理多少幅图像),通常高速抓取需要30fps以上-3。第三,看通讯与集成:您的机器人控制器品牌是什么?优先选择支持EtherCAT、PROFINET等工业总线或通用TCP/IP协议,且提供与您所用机器人品牌(如发那科、ABB、库卡)便捷接口的相机,这会省去大把集成时间-4。强烈建议“试拍”:向供应商提供您最具代表性的几个零件(包括反光最厉害和颜色最深的),要求用他们的相机在实际光照条件下进行测试,看生成的点云是否完整、稳定。实践是检验真理的唯一标准!

2. 网友“物流老李”提问:我们在仓库用3D相机测包裹体积,但传送带老是震动,包裹尺寸形状也千奇百怪,测出来老有误差。有啥好办法能提升稳定性?

答:李总遇到的这是动态物流场景的典型挑战,震动和物体多样性确实是传统测量的“杀手”。提升稳定性可以从“硬”和“软”两方面入手:

硬件加固与选型:首先,考虑相机本身的抗振动设计和防护等级(至少IP65)。对于动态场景,相机的全局快门比滚动快门更能避免图像扭曲。在技术原理上,对于您这种中距离、需要较好速度的场景,飞行时间(ToF)法或动态结构光方案值得考虑,它们对运动模糊的容忍度相对更高-3-8。

软件算法升级:这是解决复杂性的核心。现在的先进方案会深度融合AI算法。例如,用深度学习模型直接识别和分割传送带上任意形状的包裹,而不是依赖传统的几何特征匹配,这样对奇形怪状的包裹识别更鲁棒-4。同时,系统算法应具备动态校准和补偿功能,能一定程度抵消轻微震动带来的基准面误差。可以设置多帧数据融合,对一个包裹连续测量多次取最优或平均值,也能有效提升单次测量的可靠性。

流程优化:如果条件允许,在测量工位前后增加简单的物理导向机构,让包裹姿态相对稳定;或优化光照,使用均匀的补光灯减少阴影干扰,都是成本不高但很有效的辅助手段-3。

3. 网友“小白创业者”提问:想创业做智能硬件,涉及一些小零件的3D扫描建模。看到文章里提到“可编程结构光”和“高精度”,但对初创团队来说,有没有成本较低又能保证一定精度的入门方案或开源路径?

答:这位创业者朋友,非常欣赏您的务实态度。对于初创团队,在“高精度”和“低成本”之间找平衡是一门艺术。完全追求实验室级的微米精度(成本动辄数万)不现实,但利用现有资源实现“可用、好用”的毫米级精度是完全可行的。

开源硬件与软件组合:这是最具性价比的入门路径。硬件上,您可以研究基于双目立体视觉的方案,使用两个经过校准的工业相机(甚至是一些高端网络摄像头)组建您的核心成像系统。为了克服纯双目在弱纹理表面的困难,可以主动投射不可见的红外散斑图案(有现成的红外激光散斑发生器模组),这其实就是一种简易的“主动双目”或结构光思路-3。软件上,世界是开放的:OpenCV提供了最基础的相机标定、立体校正和视差计算功能;Point Cloud Library (PCL) 是处理3D点云的瑞士军刀,涵盖滤波、配准、分割所有流程-3。更有一些开源视觉SLAM项目,其前端模块就能输出不错的三维点云。

利用成熟的低成本模组:市场上已经有一些面向创客、教育和小型商业应用的集成化3D视觉模组,它们将相机、投影仪和基础算法打包,通过USB接口输出点云数据,价格在数千元级别。虽然精度和稳定性可能与工业级产品有差距,但用于原型验证、对小零件进行建模和简单测量,往往是足够的。

核心建议:创业初期,不必追求面面俱到。明确您智能硬件的核心应用对精度的最低要求是多少(比如1毫米?0.5毫米?)。然后集中火力攻克最影响该精度的单一环节(比如相机标定精度、或点云拼接算法)。通过开源方案快速搭建原型(MVP),验证市场需求和技术可行性,这比一开始就追求“高大全”的工业级方案要明智得多。随着产品迭代和资金充裕,再逐步升级核心视觉部件。